34

suche haben mehr Aussicht auf Erfolg, Mängel

in der Produktion sind wahrscheinlich und ganz

allgemein schwindet das Vertrauen in die eige-

ne Datenbasis [1]. Generell lässt sich feststel-

len, dass die Kosten umso höher ausfallen, je

später entsprechende Probleme bei den Daten

festgestellt werden. So ist eine nachträgliche

Bereinigung von Daten beispielsweise 5- bis

10-mal teurer als der rechtzeitige Einsatz von

qualitätssichernden Maßnahmen [4].

All diesen Risiken, die mit niedriger Daten-

qualität einhergehen, stehen eine Reihe

von Chancen gegenüber, welche bei hoher

Datenqualität genutzt werden können.

So

können qualitativ hochwertige Daten das ope-

rative Risiko verringern, Projekte können zu ge-

ringeren Kosten und mit reduzierten Durchlauf-

zeiten durchgeführt werden, Kunden sind zu-

friedener, und bei ausreichend hoher Qualität

kann sich ein Unternehmen auch Vorteile im

Wettbewerb mit Konkurrenten sichern [1].

Die Sicherung der Datenqualität ist dabei ein

unternehmensübergreifendes Thema. Bei allen

nachfolgend vorgestellten Maßnahmen ist stets

zu beachten, dass sie Hand in Hand mit einer

entsprechenden Organisation und Verankerung

in der Unternehmenskultur gehen müssen.

Den Dimensionen der Datenqualität lassen sich,

sofern sie verletzt werden, verschiedene Folge-

erscheinungen und -kosten zuordnen. Eine Ver-

qualität weiter sinken lässt, liegt auf der Hand.

Steigende Verluste scheinen vorprogrammiert.

Schlechte Datenqualität führt dabei zu

unterschiedlichen Arten von Kosten

Wenn Daten verifiziert werden müssen, entste-

hen Nachweiskosten. Bei der Korrektur von fal-

schen Eingaben in Datenbanken fallen soge-

nannte Wiedereingabekosten an. Indirekt kann

es auch zu Umsatzeinbußen kommen, Budgets

werden unproduktiv verschwendet, Fehlent-

scheidungen getroffen, es kann Schaden am

Image des Unternehmens entstehen, gelegent-

lich verbunden mit Gerichtskosten, Betrugsver-

liche Sprache. So gehen mehrere Autoren da-

von aus, dass niedrige Datenqualität in Unter-

nehmen Verluste von ca. 25% des operativen

Gewinns verursacht [2][5]. Eine 2010 bei 140

Unternehmen durchgeführte Studie liefert auch

Zahlen: So nannten die Befragten 8,2 Millionen

US-Dollar als durchschnittlichen Verlust durch

Probleme mit der Datenqualität pro Jahr [3].

Auch im Bankenbereich entstehen, einer weite-

ren Studie aus dem Jahr 2007 zufolge, durch

niedrige Qualität von Daten sehr hohe Kosten,

sowohl direkter als auch indirekter Natur. Letz-

tere werden zudem oft übersehen, obwohl sie

den größeren Teil ausmachen [6]. Die Gefahr,

dass eine immer größer werdende Flut unvoll-

ständig verifizierter Daten im Mittel die Daten-

Autoren

Ulrich Gürster

ist Managing Consultant bei xapio GmbH, München.

E-Mail:

Michael Spaar

ist Senior Consultant & Data Analyst bei xapio, München.

E-Mail:

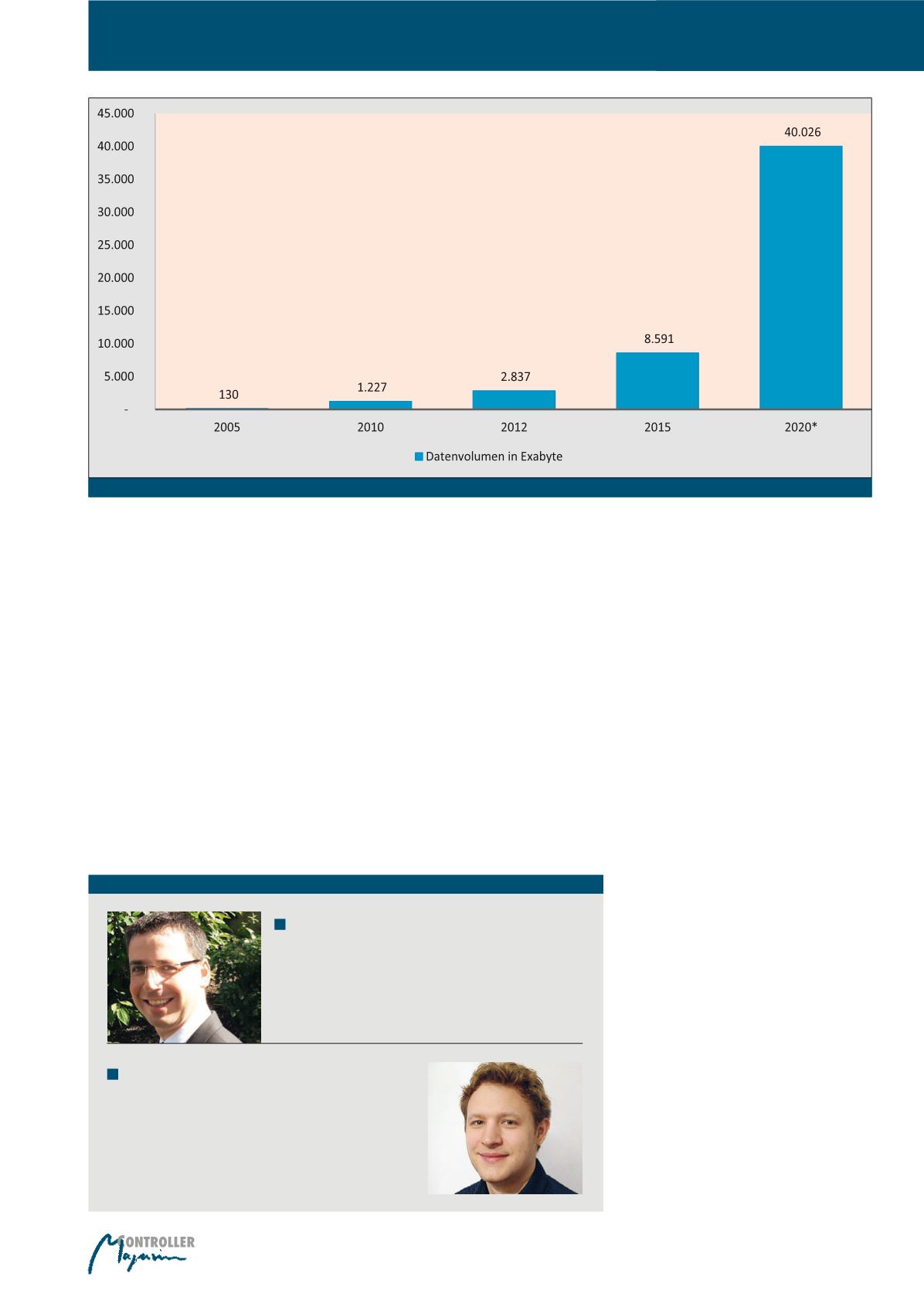

Abb. 1: Statista 2016 (Quelle: IDC)

Datenqualität in Zeiten von Big Data